Statistiquement significatif ?

Comment savoir si un évènement aléatoire est surprenant ou non ?

Aujourd'hui, on continue de parler de chiffres. Cette fois, on a va essayer de faire de la statistique tout en douceur !

Il est courant de vouloir prouver un lien entre deux choses : par exemple, « les OGM sont-ils mauvais pour la santé ? », « ce médicament soigne-t-il vraiment ? » ou encore « cette pièce de monnaie est elle équilibrée entre ses deux faces ? ».

En sciences, on cherche à prouver en général, et pas sur un cas particulier. Par exemple, si je dis « je suis centenaire car je mange beaucoup de plats avec de l'huile d'olive », il s'agit au mieux d'une anecdote : rien ne prouve que quelqu'un avec le même régime deviendra lui aussi centenaire(1).

Mais comment prouver en général ? Prenons un exemple concret, avec une pièce de monnaie : on voudrait savoir si elle est équilibrée ou non (considérons qu'une pièce déséquilibrée fera plus souvent pile que face par exemple).

Je lance ma pièce une fois, elle fait pile. Puis-je en conclure qu'elle est déséquilibrée en faveur de pile ? Évidemment que non !

Je relance ma pièce, j'obtiens pile à nouveau. Puis-je en conclure quelque chose ?

Intuitivement, on comprend que si je lance ma pièce 1 000 fois et obtient pile 950 fois, il y aura un problème, mais où placer la limite ?

Si je fais pile 600 fois, est-ce déséquilibré ou simplement dû au dieu des aléas et du hasard ? 550 fois ? 505 fois ?

Comme on le voit, dès que l'on joue avec le hasard, il est difficile de se prononcer. Après tout, à strictement parler, une pièce équilibrée pourrait bien faire pile cent fois de suite. C'est possible, mais très très improbable !

Et c'est là qu'est la clé ! Les études vont comparer une population de référence (des gens qui ne mangent pas d'OGM, des gens qui ne prennent pas de médicament, une pièce équilibrée) et regarder les différences avec l'individu comparé (ou la population).

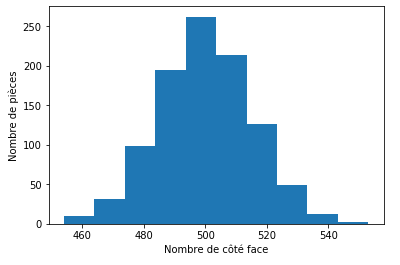

Pour définir cette population de référence, on a besoin d'exemples concrets sur le comportement habituel qui nous permettront ensuite de comparer avec ce que l'on étudie. Prenons donc mille pièces équilibrées, et lançons-les chacune mille fois : cela nous donne de bons exemples du comportement normal d'une pièce classique. On note les résultats en fonction du nombre de fois que l'on a vu le côté pile : on devrait obtenir une distribution centrée autour de 500 : en moyenne, la plupart des pièces auront autant de pile que de face, avec certaines répartitions un peu moins fréquentes. J'ai demandé un peu d'aide à l'ordinateur, et voilà le résultat :

Si on regarde la colonne notée 500, on peut voir que j'ai eu un peu plus de 250 pièces qui ont eu 500 fois le côté face, 500 fois le côté pile(2).

Si on regarde la colonne notée 460, un peu moins d'une dizaine de pièces se trouvent dans cet intervalle.

Plus généralement, plus la courbe « monte » haut, plus il est probable qu'une pièce équilibrée se trouve dans l'intervalle.

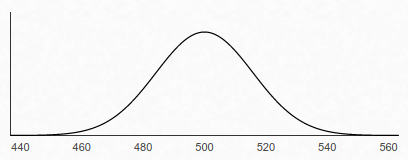

On peut « lisser » la représentation précédente en faisant encore plus d'essais : dix mille, cent milles, un million, … ou simplement en appliquant les mathématiques(3) qui nous donnent alors la courbe suivante :

On appelle ce type de distribution une distribution normale. Notez que la forme générale ressemble à une cloche, d'où le petit surnom de cloche de Gauss !

Muni de cette visualisation, on se rend compte que pour pouvoir dire que quelque chose est « significatif », il faut que ce quelque chose dévie significativement de la norme – autrement dit, qu'il soit en dehors de la répartition classique.

Si j'ai obtenu 400 fois pile et 600 fois face, je suis très en dehors de l'intervalle : il est sûr que la pièce est déséquilibrée(4) !

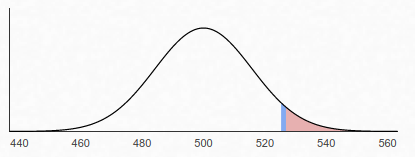

Dans la réalité, il est assez rare de sortir complètement de la cloche : on introduit donc le concept de p-valeur : il s'agit de notre intervalle de confiance, ou plus précisément de l'écart que l'on souhaite voir avec le hasard.

Par exemple, une p-valeur de 5 % signifie que l'on va regarder si notre résultat tombe dans les 5 % les plus extrêmes de la cloche :

Dans le cas des pièces, on peut calculer qu'une pièce qui fait plus de 526 fois pile sur mille lancers est déséquilibrée pour une p-valeur de 5%(5).

On trouve trois p-valeurs classiquement utilisées :

- 10% : on est peu sûr de quelque chose (il y a dix pour cent de chances que l'on se trompe)

- 5% : on est relativement sûr de quelque chose (il y a cinq pour cent de chances que l'on se trompe)

- 1% : on est très fortement sûr de quelque chose (il y a un pour cent de chances que l'on se trompe)

Plus la p-valeur est faible, plus l'on est sûr. En sciences dures, on utilise fréquemment des seuils très forts (par exemple, p-valeur de 0,000 029 % pour la détection du boson de Higgs en physique). Dans les sciences moins exactes, on ne peut pas toujours se permettre d'aller aussi loin (en biologie par exemple, on ne peut pas faire des expériences sur des millions de personnes), et l'on fixe souvent une p-valeur de 5%.

Dire de quelque chose qu'il est statistiquement significatif pour une p-valeur de 5% signifie donc que les résultats que l'on a obtenu tombent dans les 5 % les plus extrêmes d'une distribution classique.

Ça ne veut pas dire que l'on est sûr : on ne deviendra sûr que si plusieurs études confirment le résultat. À 5%, on peut juste dire que l'on a une présomption que ce que l'on étudie a un impact qui fait dévier significativement de l'habituel.

- (1) ↑ Exemple idiot : il existe des centenaires fumeurs. Ils pourraient dire que leur longévité provient de la cigarette !

- (2) ↑ En vérité, il s'agit d'un histogramme qui groupe : il est plus correct de dire que 250 pièces ont eu entre 495 et 505 fois le côté pile.

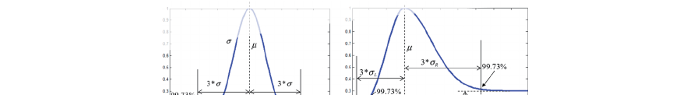

- (3) ↑ Pour les matheux qui suivent, \(\mu = 500\) et \(\sigma = \frac{\sqrt{1000}}{2}\).

- (4) ↑ En vérité, rien n'est jamais sûr, juste fortement improbable. Mais ainsi va la science…

- (5) ↑ Attention, on ne peut pas dire qu'elle a 5 % de chance d'être déséquilibrée ! On peut juste conclure qu'elle fait partie des 5 % les plus extrêmes de la distribution classique.